共计 1324 个字符,预计需要花费 4 分钟才能阅读完成。

昨天晚上,DeepSeek 又搞了个大动作——V3.1 模型正式上线。朋友圈、社群里一片热闹,大家都在刷“128K 上下文”“新 Base Model”,但是其中最重要的还是「模型融合」

省流:别被“128K”忽悠了,真正的重点是—— V3.1 把 Chat 和 Reasoning 融了!

很多人第一眼被吸引的就是“128K 上下文”,觉得这是突破。可实际上,DeepSeek V3/R1 一直都能跑 128K,只是 API 端之前只开放到 64K。这次所谓的升级,更多是“放开限制”而不是“技术飞跃”。

所以,128K 很重要,但不是这次更新的灵魂。

这次的 V3.1 最大的变化,就是把 Chat 和 Reasoning 融到了一起。以前要对话可以用 V3,要深度推理就必须使用用 R1;现在只剩一个模型。

听起来很美好:一套模型,省下部署成本,还能提升算力利用率。可是,融合的副作用也很明显——幻觉又开始频繁出现,中英文混杂的老毛病也回来了。

我个人感觉:V3.1 有进步,但远不如预期。

V3.1 更新亮点

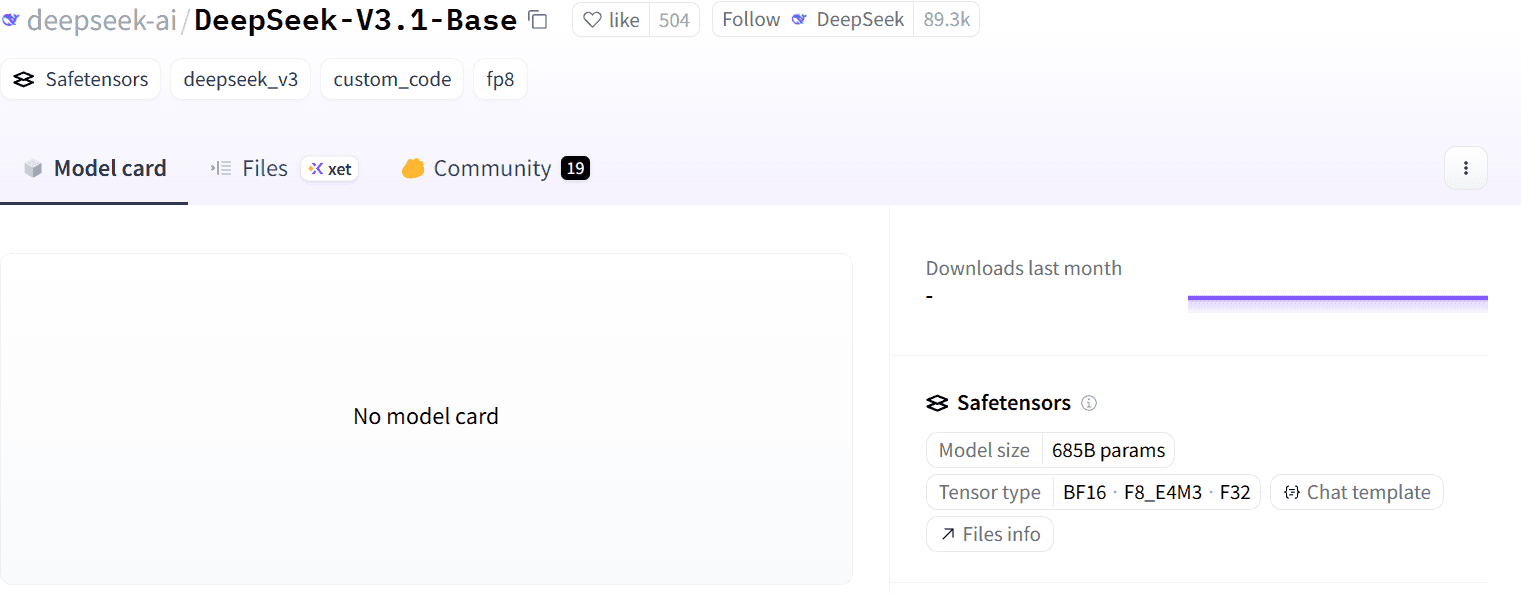

本次开源的 V3.1 模型拥有 685B 参数,且支持多种精度格式,从 BF16 到 FP8。

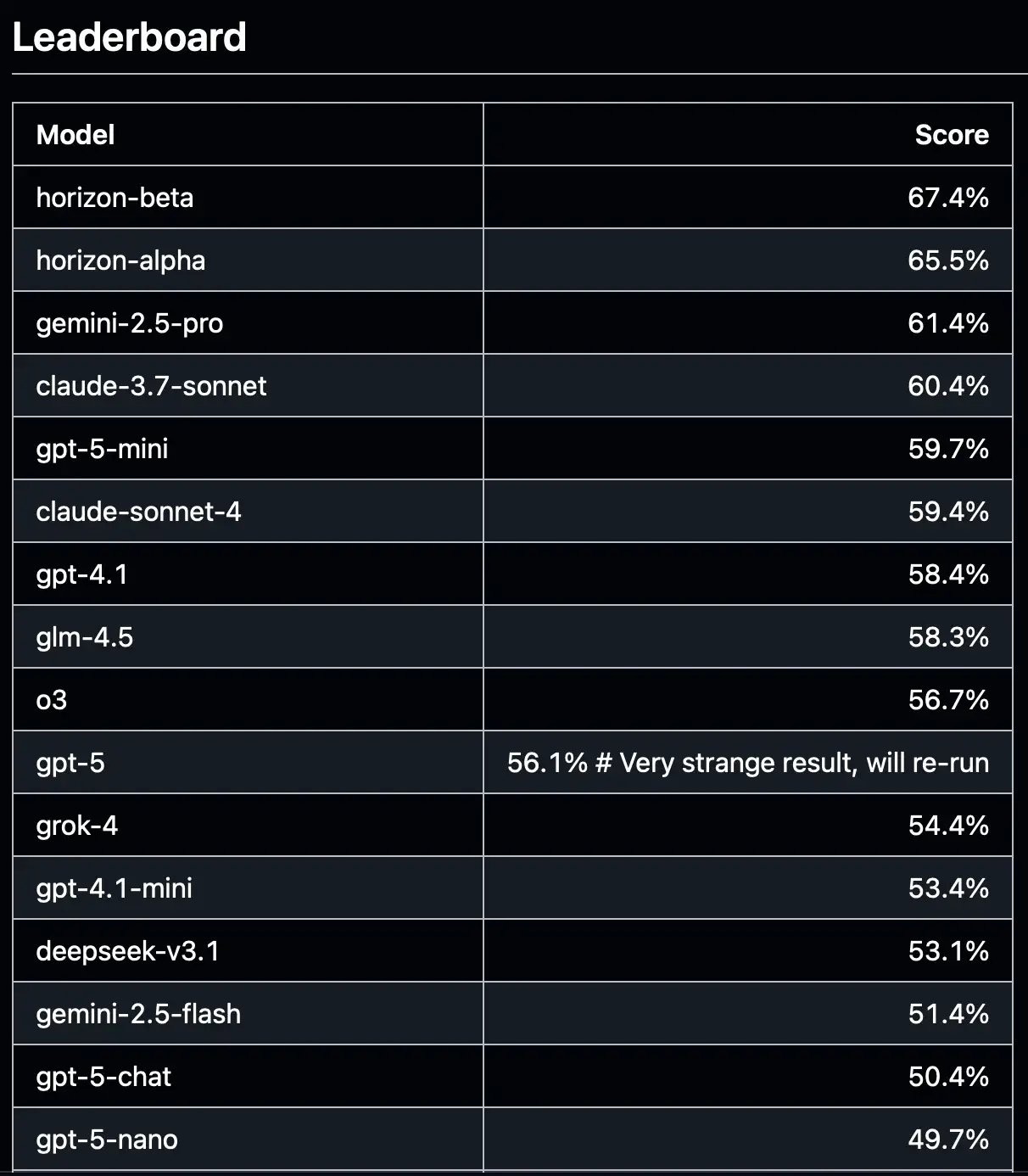

国外基准跑分(SVGBench)实测推理跑分相比 DeepSeek-R1-0528 的得分提高了 13%,总体排名第 13,最佳中国模型第 2,最佳开源权重模型第 2,以及无视觉能力模型中排名第 2

在架构上,V3.1 采用了模型融合方式,基本可以说 V3.1 = V3 + R1

成本上节约了六十分之一,完整编程任务仅需 1.01 美元

DeepSeek V3.1 Base 的模型地址已经出了,但是还没有 model card,官方的 Benchmark 成绩和能力说明还未公布

这盘棋,DeepSeek 下对了吗?

其实,这不是 DeepSeek 一家在探索模型融合的道路。Qwen3 也尝试过模型融合,结果后来还是分开出了 Instruct 和 Thinking。GPT-5 则更稳健,走的是“Chat + Reasoning + Router”路线,而不是生硬地融成一个模型,更不用说前段时间 GPT-5 被社区的人吐槽这个问题

所以,DeepSeek 的做法,究竟是“捷径”,还是“弯路”,还需要时间验证。

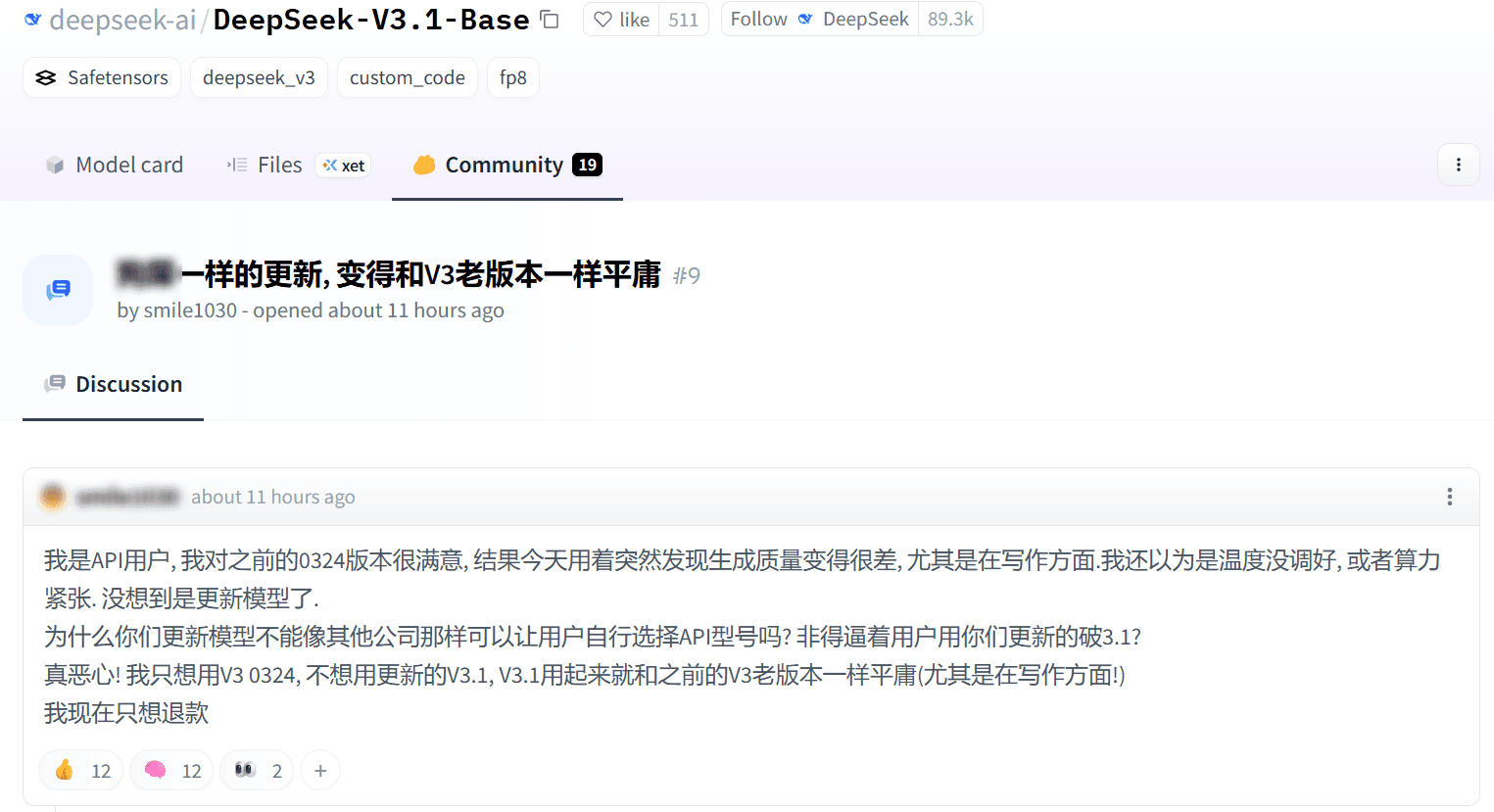

同时在 HuggingFace 上,讨论非常两极化,大部分喷的都是因为 DeepSeek 每次更新版本都会直接覆盖原始的 API 版本,会导致本身在使用老版本的用户出现问题,以及融合后的幻觉问题严重等

但同样因为 V3.1,更多的人也在期待 R2 的上线

更有意思的是,V3.1 的推出,其实和 DeepSeek 的「算力博弈」脱不开关系。根据路透社报道,DeepSeek 原本被要求用华为 Ascend 芯片训练 R2,但因为多次失败,最后只能退回 Nvidia GPU。现在的情况是: 推理用国产芯片,训练依然逃不脱英伟达。(期待国产芯片彻底摆脱 Nvidia 的一天)

这也解释了为什么 R2 始终不见踪影,而 V3.1 却急忙上线。某种程度上,它更像是“过渡产物”。所以这次的 V3.1 更像是一次实验,真正的看点,还是要等 R2 或 V4

AI 的世界,总是在“期待”与“失望”之间来回摇摆。GPT-5 前段时间也是先被骂,再慢慢赢回口碑。V3.1 也许是一次失败的实验,也可能是未来“大一统模型”的起点。

所以,我的建议是: 别急着下结论,让子弹再飞一会儿。